Quy luật 39 giây

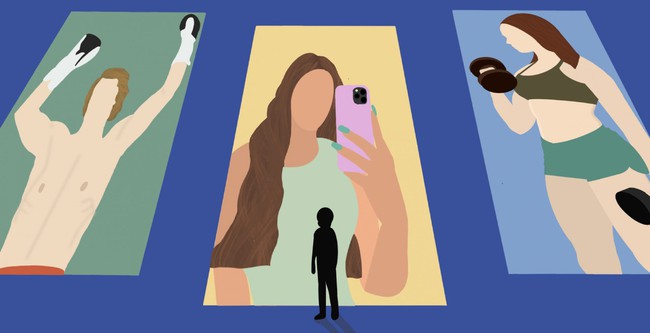

Những lời kêu gọi cấm TikTok ở Mỹ ngày càng gia tăng trong thời gian qua. Không chỉ đơn giản là những lo ngại về quyền riêng tư, thứ đáng sợ hơn cả đến từ ứng dụng này chính là thuật toán.

Một nghiên cứu gần đây đã thử tạo các tài khoản ảo dưới dạng những đứa trẻ 13 tuổi để xem TikTok dành cho lứa tuổi này những nội dung gì. Kết quả nhận về trên TikTok là tràn ngập các video về rối loạn ăn uống, hình ảnh cơ thể, tự làm hại bản thân và tự tử.

Đây không phải thông tin mới, khi Wall Street Journal vào năm 2021 đã phát hiện ra cách TikTok hướng người xem đến nội dung nguy hiểm.

Kể từ đó, TikTok đã tăng cường kiểm soát và hứa hẹn về thuật toán ổn định hơn, nhưng nghiên cứu mới đây cho thấy có thay đổi nhưng rất ít.

Trung tâm phòng chống thù địch trên môi trường số, một tổ chức phi lợi nhuận đã thử nghiệm những gì thanh thiếu niên nhìn thấy trên TikTok.

Tháng 8 năm ngoái, các nhà nghiên cứu đã thiết lập tám tài khoản TikTok sử dụng danh tính của những đứa trẻ 13 tuổi ở Mỹ, Anh, Canada và Úc.

Trong 30 phút thử nghiệm, các nhà nghiên cứu sẽ dừng lại xem trước bất kỳ video đề xuất nào về hình ảnh cơ thể và sức khỏe tâm thần, đồng thời nhấn thích các video này.

Chỉ với thao tác trên, thuật toán TikTok sau đó lập tức đề xuất các video về tự tử và rối loạn ăn uống. Các nhà nghiên cứu nhận ra video về hình ảnh cơ thể và sức khỏe tâm thần xuất hiện trên tài khoản theo quy luật 39 giây/lần.

Sau khi công bố phát hiện nói trên, nhiều video đã biến mất khỏi TikTok. Nhưng nhiều số khác vẫn còn. Trên đó có các video quảng cáo chế độ ăn kiêng và thảo luận về hành vi tự làm hại bản thân hay tự tử.

TikTok sẽ gỡ bỏ nội dung vi phạm các nguyên tắc bằng cách đề cập trực tiếp đến hành vi tự tử. Tuy nhiên, những video mà mọi người mô tả cảm giác muốn tự tử thì lại không bị coi là vi phạm.

Giới lãnh đạo TikTok cho biết nền tảng này là nơi chia sẻ cảm xúc về những trải nghiệm khó khăn và cho rằng chúng có thể hữu ích cho người xem cũng như người đăng.

Tuy nhiên, các nhà tâm lý học trẻ em nói rằng những điều đó cũng gây ra tác động có hại.

Buồn và cô đơn

Trong số 595 video mà TikTok đề xuất cho các tài khoản giả trong cuộc nghiên cứu, tràn ngập trong đó là nỗi buồn và sự cô đơn.

Chuỗi video buồn bã khiến ngay cả người lớn cũng cảm thấy suy sụp. Điều này khiến người ta tự hỏi một đứa trẻ 13 tuổi sẽ cảm thấy thế nào sau khi xem loại nội dung như vậy hết ngày này qua ngày khác?

Một tài khoản tập hợp toàn những bài nhạc "buồn và cô đơn". Một video khác có cảnh một cô gái tuổi teen khóc trong mọi video, với những tuyên bố về việc tự tử.

Những tài khoản đó cũng phát triển những cách sáng tạo để vượt qua các bộ lọc nội dung của TikTok.

Ví dụ: TikTok không cho phép nội dung đề cập đến tự tử nên các tài khoản sử dụng các từ tiếng lóng hoặc viết tắt, và phần còn lại để người xem tự mường tượng.

Một phát ngôn viên của TikTok cho biết công ty có một đội ngũ hơn 40.000 người kiểm duyệt nội dung. Trong ba tháng cuối năm 2022, TikTok đã xóa khoảng 85 triệu bài đăng được cho là vi phạm nguyên tắc cộng đồng, trong đó 2,8% là nội dung tự tử, tự làm hại bản thân và rối loạn ăn uống.

Theo Trung tâm nghiên cứu Pew, 2/3 thanh thiếu niên Mỹ sử dụng TikTok và 16% thanh thiếu niên nước này nói rằng họ sử dụng gần như liên tục.

Kiểm soát tất cả nội dung trên một dịch vụ được sử dụng bởi hơn một tỷ người dùng hàng tháng không phải là nhiệm vụ dễ dàng. Tuy nhiên, có sự khác biệt giữa việc loại bỏ nội dung có hại và quảng bá nội dung.

Arthur C. Evans Jr., giám đốc điều hành của Hiệp hội Tâm lý Mỹ cho biết: "Nếu các công ty công nghệ không thể loại bỏ những thứ như vậy ra khỏi nền tảng, thì họ cũng đừng tạo ra các thuật toán hướng trẻ em đến thông tin đó".

Tags